Кто владеет информацией, владеет всем миром. Сегодня это известное выражение Натана Ротшильда стало еще актуальнее, чем в бытность известного миллиардера. Расскажем об одном из популярных инструментов сбора информации из интернет-источников - парсинге. Итак, парсинг данных для интернет-магазинов: что, как, зачем.

Что такое парсинг информации

Так называют процесс автоматического сбора данных из сети. Для этих целей создано немало специальных сервисов - от простеньких до продвинутых. Они умеют анализировать буквально все: сайты магазинов конкурентов, социальные сети, сайты бесплатных объявлений, где есть нужная информация. Время парсинга зависит от объема данных и поставленной задачи. Важное условие: программы-парсеры умеют собирать базы только из открытых источников.

Что происходит с собранной информацией после ее автоматического сбора? Теперь ее можно использовать в любых целях: наполнять сайт товарами, собирать базы для электронных рассылок и делать многое другое.

Какую информацию можно парсить

Вообще любую, которую можно использовать в своих целях и когда речь идет о большом объеме однотипных данных. Обычно парсят товары с сайтов магазинов конкурентов, чтобы потом наполнить собственный каталог в автоматическом режиме. Но на самом деле сфера применения программ-парсеров куда шире. Расскажем об основных направлениях.

Парсить можно:

- товары из каталогов. Это одно из основных векторов для работы. Представьте: ассортимент даже небольшого интернет-магазина может состоять из тысяч и десятков тысяч позиций. Заливать их на сайт вручную долго и муторно. Придется пользоваться услугами копирайтеров чтобы писать описание товара, где-то брать картинки и изображения и прочее прочее. Сервисы делают это в автоматическом режиме: собранные данные можно сразу импортировать в собственный каталог;

- цены и динамику цен. Можно до бесконечности мониторить сайты конкурентов вручную, чтобы определиться с ценовой политикой и установить адекватные расценки. А можно прибегнуть к использованию программ-парсеров и сделать это быстро и безболезненно;

- профили пользователей, зарегистрированных в социальных сетях. Речь идет о таких данных, как пол, возраст, интересы, географическое местоположение и многое другое - все, что указывают люди на своих персональных страницах. В последующем эти данные можно использовать при проведении узконаправленных рекламных кампаний: контекстной рекламы в “Яндекс. Директ” и Google Adwords, настройках таргетинга во “ВКонтакте”, “Одноклассниках” и так далее;

- информацию о соискателях на сайтах объявлений и поиске работы и различных HR-порталах. Если вы активно набираете сотрудников в больших количествах (например, менеджеров по продажам). Те, кто сталкивался с формированием штата знают: собирать такую информацию вручную долго и трудозатратно. Нужно изучить множество профилей, изучить резюме и сделать многое другое. При помощи автоматических программ такая информация будет собрана автоматически. Большинство сервисов имеют встроенные фильтры, позволяющие выставить нужные критерии и требования к соискателям. На выходе - полный пул кандидатов, с которыми можно работать: звонить, писать и связываться по другим каналам;

Парсинг резюме

- контактные данные. Сразу оговоримся: такая информация попадает под действие закона и защите персональных данных. Поэтому так просто взять и спарсить телефоны и email-адреса, а потом транслировать на них рассылки и оповещения, попросту нельзя. Но технически это выполнимо. Обычно в виде доноров подобной информации выступают всевозможные сайты бесплатных объявлений: “Авито”, “Циан”, “Авто.ру”, CarPrice и другие;

- объемы продаж. Некоторые крупные маркетплейсы, агрегаторы и ритейлеры показывают такие данные в открытом доступе. Вы все это видели: прямо на сайте в карточке товара есть примерно такие данные: сколько единиц осталось на складе, сколько продано за сегодня и тому подобное. Подход используют такие гиганты, как “Wildberries”, “Ламода” и “Леруа Мерлен”. Зачем интернет-магазину эта информация? Да затем, что из нее можно выудить много полезного: объемы продаж конкретных позиций, их популярность на рынке, а также примерный спрос. После этого появится понимание, в какую сторону движется рынок и чем он сейчас дышит. А еще есть возможность прогнозировать спрос на определенные товары в перспективе, например, через месяц или два;

- любую другую однотипную информацию в больших объемах.

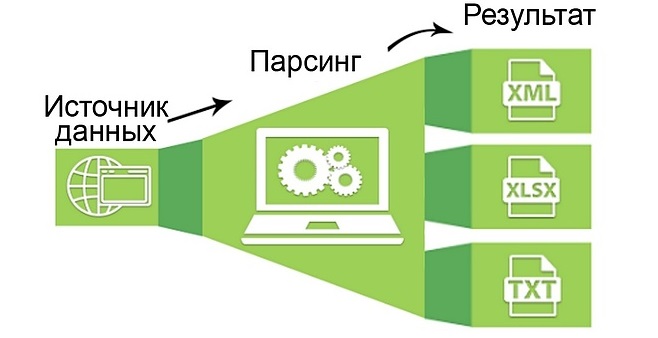

Как это работает

Для того, чтобы спарсить требуемую информацию, нужно проделать следующее:

- Определиться с тем, что собираем. Критерии поиска надо сформулировать как можно подробнее. Программы-парсеры имеют в настройках множество фильтров, которые лучше применять на полную катушку. Так данные будут более релевантными запросам и подробными. Если речь идет о сборе профилей пользователей, распишите не только пол, возраст и геолокации, но и участие в тематических сообществах, круг интересов, образование и прочие данные.

- Выбрать подходящую программу. Здесь все зависит от бюджета на проект и ваших запросов. Есть простенькие сервисы с бесплатными пробными версиями, а есть дорогостоящие профессиональные инструменты. Если парсинг требуется раз от разу и особых требований к сбору данных нет, можно начать с бесплатной площадки или использовать пробную версию крутого продукта. Второе предпочтительнее - так вы получите серьезный функционал на безвозмездной основе. В случае, когда запросы к сбору данных велики, придется оплатить подписку на один из профессиональных сервисов.

- Собственно, запустить парсинг и собрать данные. Для этого в специальном окне программы-парсера указываем адрес страницы-донора. Ну или страниц, если нужно спарсить данные из нескольких источников. Проводим настройки, выставляем фильтры и запускаем парсинг. После этого можно использовать информацию по прямому назначению. Обычно собранные данные сводятся в наглядную таблицу, но здесь все зависит от особенностей работы конкретного сервиса. Все это можно импортировать в другие места, например, в каталог сайта интернет-магазина.

Общая схема работы метода

Как выбрать подходящий сервис для сбора информации

Приводим пошаговый алгоритм выбора программы-парсера. Работа будет состоять из нескольких этапов:

- Определитесь с целями и задачами. Дело в том, что большинство программ имеют узкую направленность и универсальных инструментов мало. То есть, такого софта, который анализирует соцсети, собирает контакты с “Авито” и попутно парсит каталоги товаров почти нет. Так что если нужно собирать данные из нескольких разных областей, придется воспользоваться парой-тройкой различных площадок. А так - если нужно собрать профили под портрет целевой аудитории - надо использовать программу-парсер социальных сетей.

- Определитесь с бюджетом. Сколько денег вы готовы потратить на сбор данных? Этот критерий может оказаться ключевым при выборе программы-парсера. Как мы уже говорили, существуют бесплатные сервисы и продвинутые дорогостоящие продукты. От бюджета на проект и будет зависеть выбор сервиса.

- Обратите внимание на функционал площадки. Он должен удовлетворять списку требований к сбору данных. Если чего-то не хватает, все предприятие может пролететь впустую, когда пропущен один из ключевых параметров поиска.

- Почитайте отзывы о сервисе в интернете. Только ищите настоящие, а не фейковые, написанные самими о себе. О том, как распознать такие комментарии, мы писали ранее.

- Обратите внимание на работу службы технической поддержки. Она должна функционировать в режиме 24/7/365, то есть круглосуточно, без выходных и праздничных дней. По закону подлости все сбои в работе, требующие оперативного вмешательства со стороны поставщика услуги, происходят именно ночью в выходной. Круглосуточное техническое сопровождение будет в этой ситуации очень кстати.

- Изучите сайт поставщика услуги на предмет кейсов и тех, кто уже воспользовался сервисом. Если среди клиентов вы обнаружите гигантов интернет-торговли или просто крупные компании, это очень хорошо. Обычно найти такую информацию не составляет труда: сервисы очень гордятся сотрудничеством с компаниями федерального масштаба и охотно вываливают такую информацию на главную страницу сайта. Увидели там “Тинькофф-банк” или Mail.ru Group - все в порядке, сервису доверяют.

Список парсеров

Обзор сервисов для сбора информации

Приготовили для вас мини-подборку популярных площадок-парсеров. Среди них вы найдете сервисы для анализа ЦА, товаров и цен конкурентов. Поехали.

Targethunter

Номер один нашего списка. Почему? Именно по той причине, что площадке доверяют многие крупные компании, например, “Билайн” и “Додо пицца”. Кроме того, это один из официальных партнеров социальной сети “ВКонтакте”, а это говорит о многом. Сервис предназначен для анализа целевой аудитории в соцсетях и послужит незаменимым инструментом в работе любого SMM-специалиста.

“Таргетхантер” это:

- более 150 различных инструментов для поиска и анализа целевой аудитории;

- автоматическая загрузка собранных данных в рекламный кабинет;

- удобное управление сообществами с помощью специальных опций;

- бонусная программа. Вы получаете награду за активности, а потом деньги можно потратить на оплату сервиса и другие цели;

- круглосуточная техподдержка без выходных и праздников. По заверениям представителей площадки, среднее время ответа специалиста не превышает одной минуты.

Сервис работает на трех тарифных планах:

- бесплатный free-тариф. Здесь есть 35 инструментов для парсинга, круглосуточная техподдержка и доступ к сообществу с полезной информацией, а также доступ к закрытым чатам с экспертами по SMM;

- тариф “Стандартный”, стоимостью от 18 рублей в день при оплате за год. Это уже 130 парсинговых инструментов и более высокая скорость сбора данных;

- тариф “Автоматизация”. Цена - от 34 рублей в день. Самая высокая скорость парсинга, а также дополнительные опции: отслеживание активностей сообществах, дополнительный поток для автоматических задач и другие.

Import.io

Пожалуй, один из самых продвинутых сервисов для сбора информации о товарах в интернет-магазинах. С его помощью можно создать каталог легко и безболезненно, не прибегая к услугам программистов и других специалистов. Система анализирует карточки товаров интернет-магазинов-доноров и формирует пакет со следующими данными:

- цена;

- название;

- категория;

- материал;

- год выпуска и так далее.

Софт иностранного производства, поэтому вы столкнетесь с серьезным минусом: интерфейс доступен исключительно на английском языке. Import.io работает на двух тарифных планах - платном и бесплатном. Для большинства интернет-магазинов достаточно будет бесплатной версии продукта.

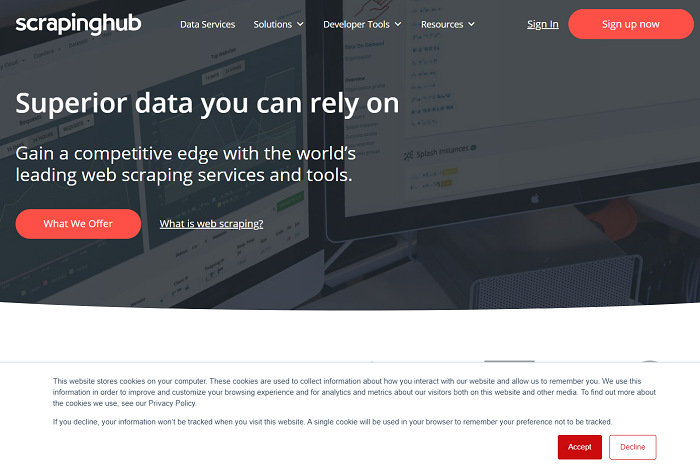

Scrapinghub

Один из немногих универсальных инструментов, позволяющих парсить информацию любого вида и формата. Программа преобразует однотипные данные с сайтов и организованный контент. Есть бесплатный тариф, дающий доступ к работе одного поискового робота. Бесплатно спарсить можно 1 гигабайт информации, далее за каждый месяц придется платить 4 доллара. Премиум-тариф запускает сбор посредством работы четырех ботов одновременно. Это будет стоить уже 9 долларов в месяц.

Минус Scrapinghub тот же - отсутствие русскоязычной версии. Правда, из-за простого и понятного интерфейса это не проблема. Техподдержка в лучших традициях: круглосуточно, без выходных и праздников.

На самом деле программ для сбора данных гораздо больше, на любой вкус и выбирайте, парсите и будьте на голову выше конкурентов. Удачи!