В органическую выдачу попадают только проиндексированные ресурсы. Когда пользователь вводит запрос в поисковую строку, система просматривает базу с миллиардами просканированных веб-страниц. Затем с учетом разных факторов отбираются и показываются релевантные ответы. Как проверить индексацию и сделать так, чтобы сайт интернет-магазина оказался в поле зрения поисковых роботов – об этом наша сегодняшняя статья.

Цели и особенности индексации страниц

Процесс индексации состоит из нескольких этапов:

- Сканирование и обработка информации.

- Анализ контента.

- Добавление в индекс.

- Работа поисковых алгоритмов.

- Выдача результатов, релевантных запросам пользователей.

Индексация – процедура считывания, анализа и загрузки содержимого веб-страниц в базу данных, которая используется для поиска информации на сайтах. По сути это сканирование документа роботом с последующим включением в поисковый индекс.

За счет собранной информации поисковики ориентируются в тематике сайтов и наполнении отдельных страниц. Эти сведения приводятся в удобный для поисковых алгоритмов формат и хранятся в индексе, дополняются деталями и заменяются новыми версиями веб-страниц, обнаруженными при повторных визитах.

Во время сканирования робот проверяет, разрешена ли индексация, загружает и разбирает мета-теги, тексты, видео, изображения, служебную информацию и прочий контент. Полезность данных определяется по внешним ссылкам, активности посетителей, объемам трафика.

Главная цель индексации для сайта интернет-магазина – иметь возможность:

- участвовать в поиске;

- конкурировать с основными соперниками в нише;

- получать органический трафик и стабильный поток целевых посетителей.

В процессе индексирования систем «Яндекс» и Google есть некоторые отличия. Googlebot первым делом оценивает мобильную версию веб-страниц. Индексация выполняется достаточно быстро: от нескольких минут до 7 дней. В постоянно обновляемый индекс попадают все просканированные данные. В выдаче по запросам оказываются самые качественные страницы, релевантность которых проверена по более 200 факторам ранжирования.

Особенности индексации в Google

Индекс в «Яндекс» обновляется раз в несколько дней. Система работает медленнее Google. Процесс индексирования может выполняться от 7 до 30 дней. В выдаче поисковика отображаются максимально релевантные документы с понятной, полезной и удобной в использовании информацией. Некачественные веб-страницы удаляются из индекса.

Условия попадания страниц в индекс

В индекс попадают те страницы сайта, которые посетил и счел полезными поисковый робот. Если страница осталась не проиндексированной, значит робот еще не дошел до нее или расценил, как неважную. Найти такую страницу через поиск в «Яндекс» или Google будет невозможно.

К непопаданию в индекс приводят такие ошибки и нарушения:

- отсутствие или небольшое количество уникального релевантного контента;

- низкая скорость загрузки;

- глубокая вложенность страницы по отношению к главной;

- высокий процент отказов;

- автоматическая генерация контента;

- ошибки кодировки в тексте;

- некорректный код ответа сервера;

- неправильное заполнение robots.txt;

- множество мусорных, спамных и малополезных страниц, дубликатов;

- использование недопустимого контента, информации, запрещенной законодательством.

Плохое индексирование вероятно из-за ошибок в выборе главного зеркала, наличия вирусов или наложенных санкций. Зачастую роботы не доходят до определенных веб-страниц по причине отсутствия ссылок на них в sitemap.xml и внутренней перелинковке. Иногда проблема заключается в случайных запретах на индексацию отдельных разделов/страниц.

Инструменты управления поисковыми роботами

Чтобы попасть в индекс, нужно прежде всего решить все потенциальные проблемы. Только после этого можно приглашать бота на сайт для новой или повторной проверки и обработки данных.

Если ресурс появился в сети недавно, необходимо представить его поисковым системам, используя инструменты «Яндекс» и Google. Второй вариант – привлечь робота ссылками, размещенными на сторонних, уже проиндексированных ресурсах: в социальных сетях, на форумах и любых других площадках, близких по тематике.

Поисковые боты могут найти и проверить веб-сайт самостоятельно. Но полагаться на это полностью не стоит. Надежнее сообщить о ресурсе, нуждающемся в индексации, через специальные формы в сервисах поисковых систем.

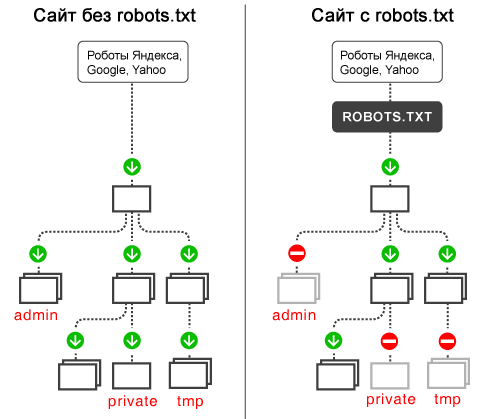

Влиять на процесс можно с помощью двух файлов – robots.txt и sitemap.

Robots.txt – текстовый файл с параметрами индексирования, размещаемый в корневой папке ресурса. При обходе боты ориентируются на прописанные в нем данные, благодаря чему могут не тратить время и лимиты на проверку маловажных данных. Файл должен весить не более 32 KB и содержать правильно оформленные типы директив:

- User agent – определяет робота, на которого распространяются правила.

- Disallow – применяется для запрета индексирования отдельных разделов и веб-страниц.

- Sitemap – отмечает местоположение карты сайта.

- Allow – разрешает индексацию определенных разделов/страниц.

Перед загрузкой файла нужно проверять его на правильность в панелях веб-мастера.

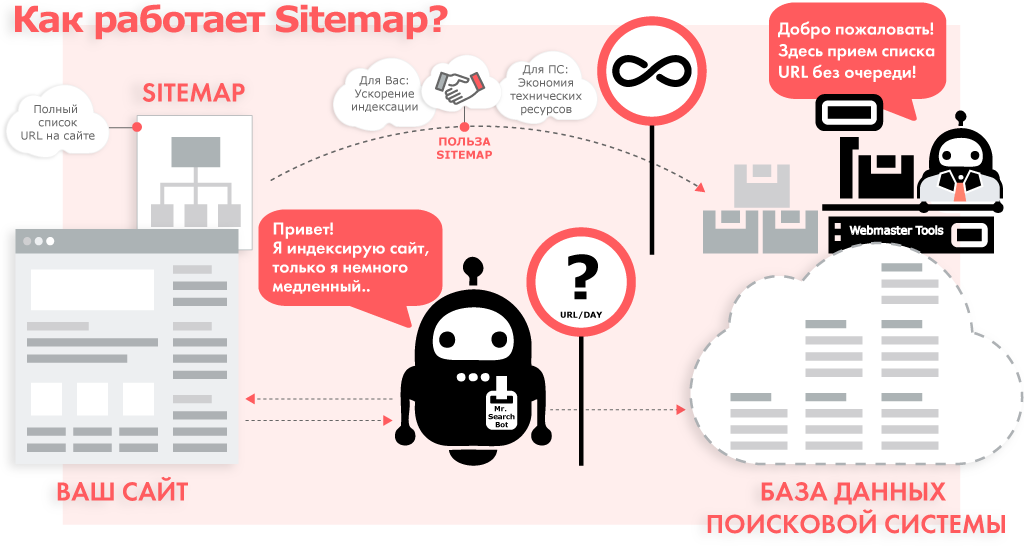

Файл sitemap оповещает поисковые системы об актуальной на данный момент структуре ресурса, помогает выставить приоритеты для проверки. В нем указывается частота обновлений и другая ценная информация, которая необходима для максимально точного индексирования. Например, тип и лицензия изображений, длина и категория видеороликов и прочее. Sitemap особенно важен для объемных площадок с множеством страниц, на которых присутствует мультимедийный контент.

Как «пригласить» поискового бота:

- создать sitemap;

- вставить ссылку на карту в robots.txt;

- добавить файл в веб-службы поисковиков;

- отправить запрос на сканирование.

Более простой способ – добавить сайт с помощью запроса «Add URL» в поисковой строке соответствующей системы.

Скорость сканирования будет зависеть от многих критериев. Учитываются:

- настройки в панели веб-мастера;

- скорость работы ресурса;

- количество страниц/разделов;

- краулинговый бюджет.

Краулинговый бюджет – это максимальный лимит URL-адресов, выделенный для проверки одного веб-сайта в заданный период времени.

Способы проверки индексации

Проверить присутствие сайта, разделов и страниц интернет-магазина в индексе можно несколькими способами.

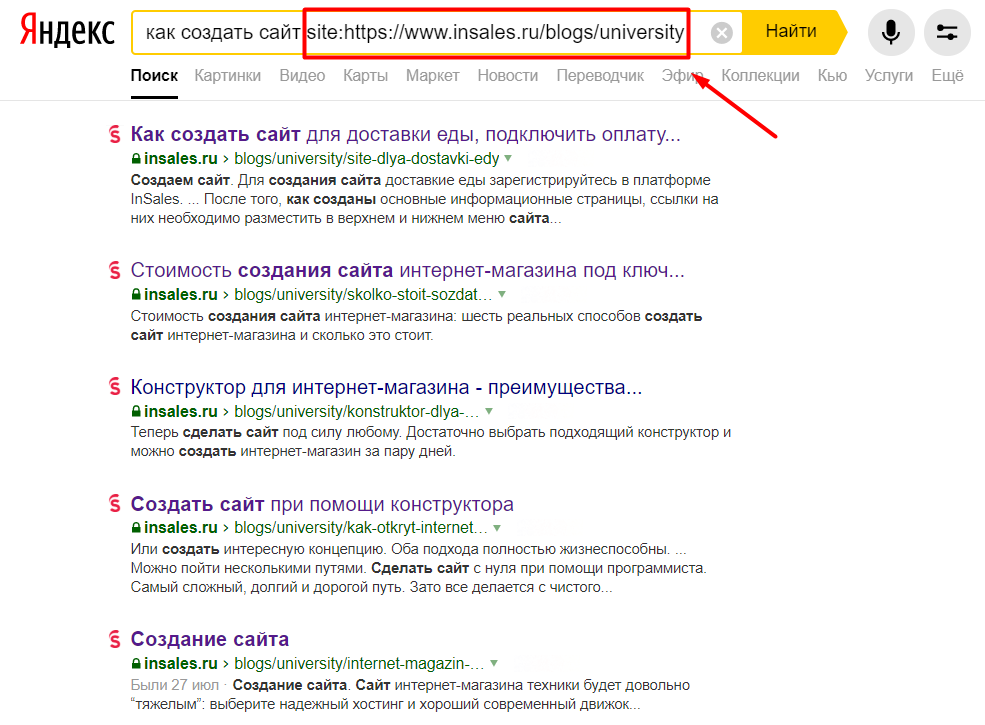

Поисковые операторы в запросах

Самый простой и быстрый способ ручной проверки – уточненный поисковой запрос с использованием оператора «site:». Он позволяет получить общую информацию о примерном количестве проиндексированных веб-страниц ресурса.

Запрос пишется в формате «site: [url сайта/раздела/страницы]». Для просмотра даты последнего сканирования вводят «cache: [адрес веб-страницы]». Результаты выдаются по поддоменам и основному домену.

С помощью дополнительных инструментов можно посмотреть данные о сканировании за конкретный период: последний час, сутки, неделю, месяц, год. Если на ресурс наложены какие-либо фильтры или санкции, ссылка может не отображаться. В таком случае следует вводить запрос через специальных операторов «inurl:» и «url:». При отсутствии страницы в индексе в выдаче будет показан пустой результат.

Чтобы понять, есть ли проблемы с индексацией и каков их масштаб, нужно сравнивать фактическое количество страниц с проиндексированным. Серьезная разница говорит о том, что поисковая система не видит большую часть контента. Также о проблемах свидетельствуют различия по показателям в «Яндекс» и Google. В основном это означает, что сайт находится под фильтрами.

Панели вебмастера

Базовые инструменты проверки для владельцев ресурсов – Google Search Console и «Яндекс.Вебмастер». В них выводятся детализированные сведения обо всех страницах сайта, по которым легко определить, что именно не проиндексировано и по какой причине.

Алгоритм проверки в Google:

- зайдите в Search Console – «Статус индексирования» – «Индекс»;

- оцените видимость и количество адресов в индексе;

- перейдите в график «Покрытие» во вкладке «Обзор»;

- обратите внимание на цвета: проиндексированные страницы без ошибок отмечены зеленым, с ошибками – красным;

- откройте отчет и просмотрите детализацию выявленных ошибок;

- для проверки присутствия в индексе определенной страницы/раздела вставьте нужный URL в поисковую строку;

- после внесения изменений отправьте запрос на переиндексацию, нажав на соответствующую кнопку;

- воспользуйтесь той же кнопкой для постановки новых данных в очередь на сканирование.

Алгоритм проверки в «Яндекс»:

- внесите URL-адрес ресурса в форму и подтвердите права владельца;

- зайдите в «Яндекс.Вебмастер», пункт «Индексирование сайта»;

- откройте категорию «Страницы в поиске»;

- перейдите в «Историю» и посмотрите динамику изменения числа веб-страниц ресурса, участвующих в поисковой выдаче (количество качественных разделов без ошибок должно расти и добавляться в индекс).

Плагины и скрипты

Плагины и скрипты – вариант для автоматизированных проверок. Это специальные расширения для браузеров, которые работают по аналогичным принципам. Чтобы получить интересующую информацию в один клик, не нужно ничего настраивать и прописывать: достаточно открыть сайт для проверки и активировать плагин.

В ТОП-3 популярных инструментов входят:

- Seo Magic – отображает количество проиндексированных адресов, ТИЦ, АГС.

- RDS Bar – проверяет общий индекс ресурса, индексацию и позиции текущей веб-страницы в различных поисковых системах, обратные и входящие ссылки.

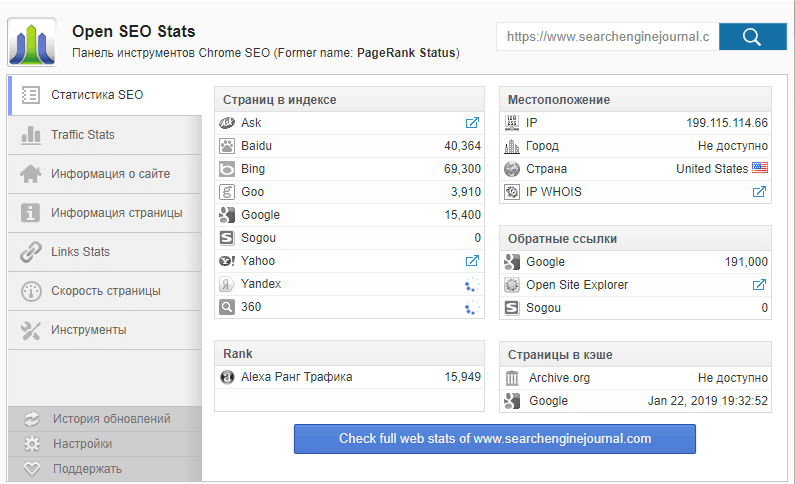

- Open SEO Stats – показывает статистику по количеству адресов в индексе, подробную информацию о страницах, внешних ссылках, скорости загрузки.

Онлайн-сервисы

Альтернатива плагинам – различные онлайн-сервисы. Помимо проверки индексации, они предоставляют много дополнительных функций и данных, помогают обнаружить вероятные проблемы в этом направлении. Примеры автоматизированных сервисов – Rush Analytics, SEO-reports, «Топвизор».

Функции Rush Analytics:

- проверка индексации;

- мониторинг поисковой выдачи, изменений заголовков, тегов и текстов;

- проверка позиций по регионам и городам;

- анализ конкурентов.

Возможности SEO-reports:

- фиксация истории индексирования;

- подсчет вывода в ТОП выдачи;

- автогенерация и рассылка отчетов в динамике по данным систем аналитики;

- ведение статистики посещений;

- формирование графика ссылочной массы.

Функционал сервиса «Топвизор»:

- постраничная проверка индексации;

- предоставление отчетов в динамике по позициям в выбранных поисковых системах;

- работа с семантическим ядром ресурса;

- анализ конкурентов.

Инструменты сервиса «Топвизор»

Как ускорить индексацию?

Иногда, даже при отсутствии явных проблем, которые могли бы препятствовать индексированию, адрес долгое время не появляется в выдаче поисковых систем. В некоторых случаях нужно просто подождать. Процесс сканирования молодых, только запущенных ресурсов может растянуться на несколько месяцев.

Ускорить индексацию помогут следующие эффективные шаги:

- Увеличение количества ссылок. Внешние и внутренние ссылки – дополнительное преимущество в индексации. Следует ссылаться на важные страницы в социальных сетях, текстах и главных разделах сайта. Кроме новых посетителей, ссылки приведут на площадку и поисковых роботов.

- Актуализация карты. Все новые разделы и любые данные сайта должны автоматически попадать в карту. Так роботам легче определить адреса, обязательные для посещения.

- Создание уникального контента и удаление дублей. Малополезный и неуникальный контент, а также страницы-дубли зря расходуют краулинговый бюджет. Такие данные нужно безжалостно удалять.

- Контроль внутренних редиректов, битых ссылок. Редиректы и гиперссылки, ведущие на несуществующие адреса – враги индексации, из-за которых робот не доходит до рабочих страниц.

- Правильная настройка стандартов для роботов. Важные адреса должны быть доступны для поисковых ботов и открыты для сканирования.

- Оптимизация скорости загрузки. То, насколько быстро загружаются данные, влияет на показатели качества ресурса. Скорость загрузки не должна быть больше 3-5 секунд.

- Регулярные обновления. Поисковики более благосклонны к «живым» площадкам. Поэтому необходимо постоянно поддерживать актуальность ресурса: добавлять новые товары, категории, материалы, обновлять устаревшую информацию.

Заключение

Индексация всех открытых страниц – одна из наиболее важных целей для любого ресурса. Чтобы достичь ее, нужно контролировать процесс сканирования и добавления адресов в индекс, оперативно реагировать на сигналы о потенциальных проблемах. Главные условия успешного индексирования – качественная оптимизация, правильные настройки и полезный, релевантный контент.